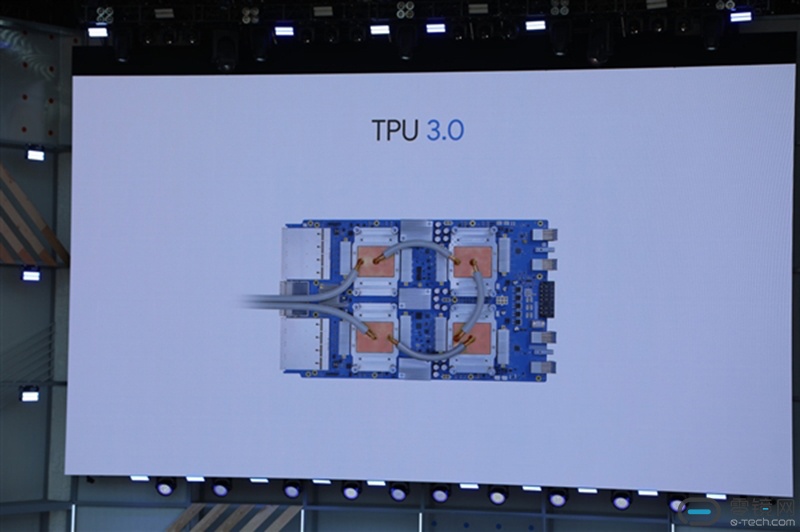

说到深度学习这款,NVIDIA可谓赚得盆满钵满,因此也引来众多巨头的眼红。谷歌就向NVIDIA发起了挑战!谷歌 I/O 2018开发者大会期间发布了第三代AI人工智能/机器学习专用处理器TPU 3.0,TPU 3.0的计算能力最高可达100PFlops(每秒1000万亿次浮点计算),是去年TPU 2.0的8倍多。

TPU 3.0与传统GPU图形芯片相比使用了8位低精度计算节省晶体管,既能对精度影响很小,又能大幅节约功耗、加快速度,同时还有脉动阵列设计,优化矩阵乘法与卷积运算,并使用更大的偏上内存,减少对系统内存的依赖。更多技术细节还有待谷歌进一步公布……

TPU(即:Tensor Processor Unit)是谷歌研发的针对深度学习加速的一款机器学习定制的专用芯片(ASIC),专为Google的深度学习框架TensorFlow而设计。第一代TPU仅能用于推断(即不可用于训练模型),并在著名的AlphaGo人机大战中提供了巨大的算力支撑。去年5月谷歌发布了TPU 2.0,不仅能进行推断,还能高效支持训练环节的深度网络加速。

据悉TPU 3.0第一次使用了液冷散热,可以更高效地服务数据中心,便于定制硬件方案。这一点狠重要!!!因为从TPU 1.0到TPU 2.0谷歌并没急于推进TPU芯片的商业化,而是做了大量的生态系统培育工作。当然TPU作为一种ASIC芯片方案,意味着其巨大的研发投入和市场风险,而其背后的潜在市场也是巨大的。

目前,为开发者创造最强机器学习工具的竞争非常激烈,能够锁定开发者到自己的生态系统的公司会比对手有更强的优势。谷歌现在正寻求扩张自己的云平台业务,如果一旦谷歌将来能为AI开发者提供相比购买GPU更低成本的TPU云加速服务,借助TensorFlow生态毫无疑问会对NVIDIA构成重大威胁,并和亚马逊旗下AWS和微软旗下Azure展开激烈竞争。所以此时推出更为强劲的AI芯片就显得尤为重要了!如果将来TPU云服务无法获得巨大的市场份额从而降低单颗TPU的成本,谷歌将难以在这一市场盈利。

谷歌在TPU芯片的整体规划是,一个横跨训练和云端推断的庞大云服务,基于自家开源、目前在深度学习框架领域排名第一的TensorFlow,结合谷歌云服务推出TensorFlow Cloud,通过TensorFlow加TPU云加速的模式为AI开发者提供服务,谷歌或许并不会考虑直接出售TPU芯片。如果谷歌的AI芯片可以让开发者能够加速他们的操作运营,这可以帮助谷歌持续吸引他们进入谷歌的生态系统。

写在最后

人工智能应用仍远未成熟,各人工智能技术服务商在深耕各自领域的同时,逐渐由人工智能软件演进到软件+芯片解决方案是自然而然的路径,因此形成了丰富的芯片产品方案。但芯片往往只是一个复杂系统中的一部分,芯片设计厂商(或者方案商)提供给客户的已经远远不止芯片本身,而是一套完整的软硬件解决方案。谷歌之所以敢于并能自己设计TPU芯片,与Tensorflow布局和以及data center方面的经验分不开的。绝大多数Deep Learning用户看到的是Tensorflow(或者其它训练框架)和CUDA,而不是底层硬件。因为对于一个AI芯片项目来说,考虑整个软硬件生态,要比底层硬件架构的设计重要得多。

同时,我们也观察到NVIDIA、英特尔等巨头逐渐也意图形成端到端的综合人工智能解决方案体系,实现各层次资源的联动。简而言之,这个领域是巨头玩家的战场,普通初创公司来到这个领域几乎没有任何机会。比如国内寒武纪,想要在这个领域扎根还得完善的自己的软硬件生态(做硬件,吃软饭)。接下来的关键看点是:谷歌究竟是否能凭借TensorFlow+Google Cloud+TPU 3.0生态取得对NVIDIA的相对优势,以市场份额的量变引起质变。

横排-无底-140x48mm-04-1.png)

竖排-无底白字-280x96mm-04.png)