俗语有云:“一个好名字是好的开始”。显然,深圳市光场视觉有限公司在名字上已经成功了一半。

12月28日,成立于2016年9月的光场视觉团队举办活动,发布旗下产品光场眼镜Gglass、手动捕捉控制器VPC以及空间定位器PSD。

光场眼镜Gglass:80g、150°FOV、AR+VR

根据光场视觉COO赵清泉的介绍,针对目前AR/VR行业的痛点,比如晕眩、清晰度不足、视场角小、体积重量大等等,推出光场眼镜Gglass。采用离轴投影技术,光场眼镜Gglass能够实现视网膜级清晰度(2560*1440)、无色散、无纱窗效应;FOV还可以达到150°,而重量可以做到80g。此外,还具备VR/AR模式切换的功能。

说得如此惊艳,但现场并没有设置体验环节。事实上,关于这套产品的进一步细节,光场视觉并没有给出过多的信息。光场视觉创始人王一中表示,产品将在3~4个月之后推出,届时再做详细解答。目前,该团队的进程是,“产品在做产品ID和结构阶段”,赵清泉说。

由此,上述的参数配置无从验证。尤其对于光场眼镜Gglass只有80g这个说法。稍微有常识的朋友都知道这个数据有点问题。对此,赵清泉在会后的采访中向零镜网表示:“眼镜只是头显部分是可以做的80克的,采用特殊的订制屏甚至50g都有可能,不过一体机就做不到了。”

显然,光场眼镜Gglass只有显示部分,计算部分由手机和 PC完成。“普通的手机电脑都可以支持,我们(给光场眼镜)留了两个接口,一个是USB,另外一个是HDMI”,王一中说。

至此,你很可能觉得光场眼镜Gglass只是一款单纯的VR眼镜,毕竟它把诸如PS VR、Oculus Rift等产品视为竞品,并试图通过80g、150°FOV等参数的比拼来吊打对方。似乎,“光场”的存在更像一个品牌名,换成“威震天”丝毫没有违和感。

当然,实际情况并非如此。对此,赵清泉表示:“光场眼镜本质是AR,为了兼容VR才加了VR、AR切换。也是为了拓展产品的应用范围,毕竟现在VR内容比较多,尤其是手机端。VR头盔,不管是国内还是国外的产品,不管是PC端还是移动端,并不想把它们作为对标对象。但是我们光场眼镜有VR功能,所以对比一下而已。”

所以,究竟什么叫光场眼镜?由于光场视觉担心泄漏商业机密,现场的演讲总是点到即止。由此,在场的专家掌网科技CTO孙其民和联络互动研究院院长杨亚军也不方便发表相关评论。

但我们总有办法知道。

光场的记录和显示

在真实世界中,由各种光源发出的光线经介质和物体时发生光学作用(折射、反射、散射等)后形成的所有光线的向量场叫做光场,也可以称为物理光场。

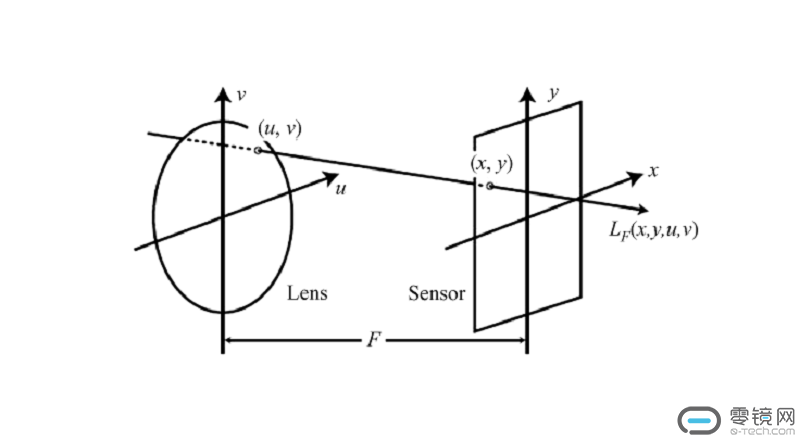

一般情况下,我们说的光场是数字光场的简称。而光场技术是通过数学函数来描述空间中所有光线的计算方法。目前,最为普遍使用的光场技术或者说计算方法是四维光场函数(下图)。

简单粗暴来说,人能看到所有光线的集合就叫光场。目前,光场技术有两个主要应用方向,一个是光场记录 ,另一个是光场显示。

在光场记录领域就是光场相机。目前,业界有三种原理获取光场:微透镜阵列解决方案、相机阵列方案、掩膜及其他孔径处理方案。

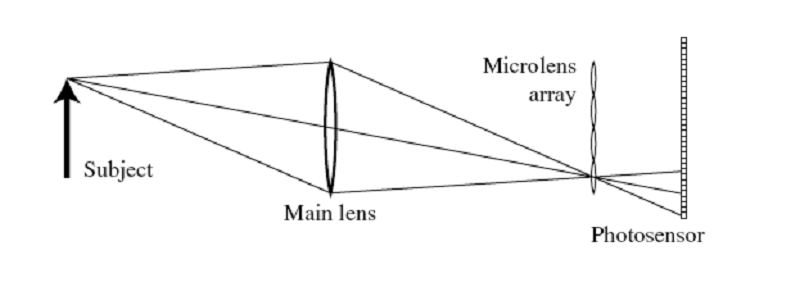

业内知名的Lytro相机就是采用微透镜阵列原理,通过在普通相机镜头(主镜头)焦距处加微透镜阵列实现记录光线,再通过后期算法(傅里叶切片定理,光场成像算法)数字变焦。具体来说,它的光场传感器在标准传感器上安装了微透镜阵列。通过这些微透镜阵列及相机内部空间,光场传感器能够捕捉包括方向等在内的1100万条光线数据。

上图来自Lytro创始人Ren Ng发表的光场相机文章《Light Field Photography with a Hand-held Plenoptic Camera》。

至于另一个用途光场显示,也就是本文主角——光场视觉团队所做的事情?

绝对不是。

大名鼎鼎的Magic Leap所做的事情就是光场显示。即使估值达45亿美元,背后有谷歌阿里撑腰,都被曝出视频造假。究其原因,Magic Leap所需要的光场计算量大,光场数据量大,存储和传输都将面临问题。

光场显示是指能在显示端还原出光线的颜色、位置、方向。目前,多数VR设备的画面光线都是从一个显示屏平面发出来的光,但在现实世界中,光线来自四面八方。事实上,为了实现光线来自“四面八方”,学术界有一种解决方案。

在2015年洛杉矶举行的国际图形学年会上,斯坦福教授Gordon?Wetzstein向人们展示了一种新型头显,其特点是由两块的LCD堆叠而成,并呈现不同的图像信息。如上图,前面和后面的LCD呈现的图像信息不一,从而使用户获得图像的深度信息。

所以,在显示端还原光场意味着,画面中的每一个像素点都将会成为一个计算单元。这绝对不是支持手机和普通电脑的光场眼镜Gglass可以完成的事情。

也因此,光场视觉团队用了一个词语“光场视觉”来概括他们所做的事情。在他们的理解中,光场视觉技术具备关键的要素是:三维立体点阵图像、单眼景深、能同时看到真实世界和虚拟图像、能在场景中自由走动和观察。他们认为通过光场视觉技术可以实现两大目标:第一,视网膜级清晰度,第二,还原全维光场(这里需要一个问号),并与此进行实时交互。

在会后的采访中,王一中表示,符合光场眼镜Gglass的内容无法通过现有的二维内容进行转换,需要特殊的设备采集相应的内容。此外,也会支持通过插件渲染CG的内容。所以,按照目前的信息量来说,留给光场视觉团队的问题不是如何显示整个光场,甚至不是内容问题,而是如何通过算法实现一种光场视觉效果(视觉效果!),或者模拟出景深的感觉。

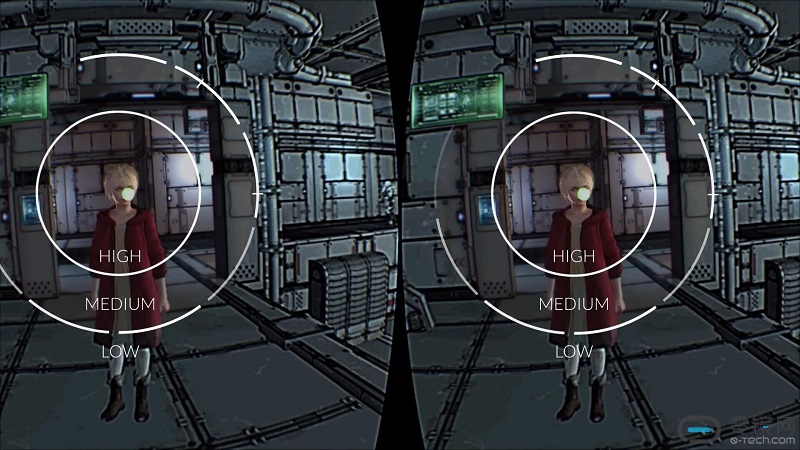

模拟这种具有景深的感觉,业内有一种非光场解决方案:利用眼球追踪对显示画面进行焦点调整,让人眼产生景深的错觉。来自日本的FOVE就是在做这件事情。如上图,以注视中心为焦点,分成焦点不一样的三个区域。但光场眼镜Gglass中并没有采用追踪眼球的设备,“本来想加,后来觉得没必要”,赵清泉补充道。

到了文章的结尾,小编并不想得到一个怎样结论,因为在没有体验,没有产品,以及他们没有详细与行业沟通之前,关注只是为了了解。最后,欢迎有不同见解的行业人士与小编交流。

横排-无底-140x48mm-04-1.png)

竖排-无底白字-280x96mm-04.png)